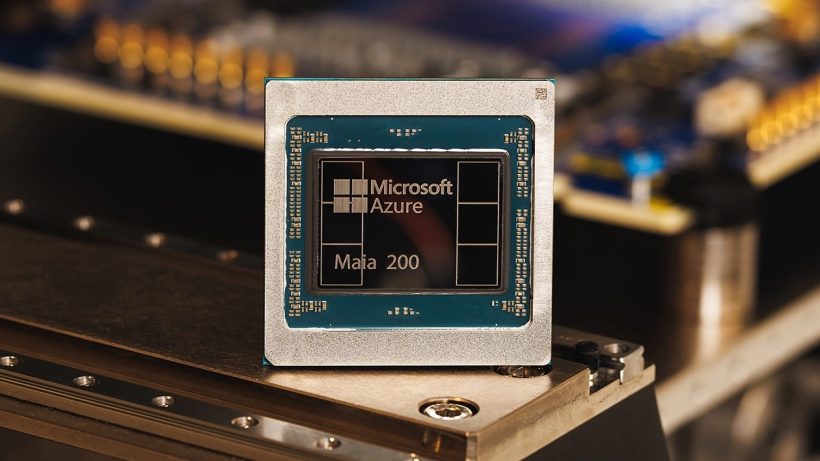

Microsoft Maia 200 – ШІ-чіп з 216 ГБ HBM3e, TDP 750 Вт та 10 PFLOPS

02.02.26

Microsoft офіційно анонсувала свій серверний ШІ-прискорювач Azure Maia 200 – чіп другого покоління лінійки Maia, розроблений спеціально для інференсу моделей штучного інтелекту. Компанія називає його найефективнішою інференс-системою у своїй історії та заявляє про приблизно 30% вищої продуктивності на кожен витрачений долар порівняно з Maia 100.

Архітектура та техпроцес

Maia 200 виробляється за 3-нм техпроцесом TSMC і містить близько 140 млрд транзисторів. За даними Microsoft, чіп забезпечує до 10 петафлопс продуктивності у обчисленнях FP4, що приблизно втричі перевищує показники Amazon Trainium3. Прискорювач оснащений 216 ГБ пам’яті HBM3e із пропускною спроможністю 7 ТБ/с, а також має 272 МБ вбудованої SRAM.

Підхід до роботи з пам’яттю

Окремий акцент компанія зробила на архітектурі пам’яті. Вбудована SRAM розділена на Cluster-level SRAM (CSRAM) та Tile-level SRAM (TSRAM). Такий поділ дозволяє більш ефективно балансувати навантаження між швидкою локальною пам’яттю та HBM, що позитивно впливає на стабільність та енергоефективність при роботі з форматами FP4 та FP8, які є ключовими для сучасних інференс-моделей.

Енергоспоживання та ефективність

Незважаючи на те, що заявлений TDP Maia 200 на 50% вище, ніж у Maia 100, Microsoft стверджує, що загальна енергоефективність зросла. Для порівняння, Nvidia Blackwell B300 Ultra має TDP близько 1400 Вт, тоді як Maia 200 працює на рівні 750 Вт. У той же час Maia 100, що номінально розраховувався на 700 Вт, на практиці споживав близько 500 Вт.

Порівняння з конкурентами та позиціонування

Безпосередньо порівнювати Maia 200 з рішеннями Nvidia компанія не береться, оскільки чіп не продається стороннім клієнтам, а програмна екосистема Nvidia залишається значно зрілішою. Втім, з погляду енергоефективності власне рішення Microsoft виглядає переконливо — особливо на тлі зростаючої уваги до екологічного впливу ІІ та споживання електроенергії датацентрами.

Розгортання в датацентрах Azure

Прискорювачі Maia 200 вже працюють у датацентрі Azure US Central. Найближчим часом Microsoft планує розширити їх використання у US West 3 (Фінікс, Арізона), а також в інших локаціях. Чіпи стануть частиною гібридної інфраструктури, де Maia 200 працюватиме разом з іншими ши-прискорювачами Azure.

Не пропустіть цікаве!

Підписуйтесь на наші канали та читайте анонси хай-тек новин, тестів та оглядів у зручному форматі!

Огляд смартфона Oppo A6 Pro: амбітний

Новий смартфон Oppo A6 Pro – середнячок з функціональністю смартфонів преміум-класу. Виробник наділив його кількома характеристиками, властивими більш дорожчим телефонам. Але не обійшлось і без компромісів. Як саме збалансований Oppo A6 Pro – розповімо в огляді.

Огляд смартфона Oppo Reno 15 5G: впевнений

Смартфон Oppo Reno15 робить ставку на дизайн, якісний дисплей, універсальні камери та гарну автономність. Розкажемо докладніше

Microsoft додала до Блокноту підтримку зображень Microsoft оновлення

Microsoft продовжує розширювати можливості оновленого Блокнота у складі Windows 11. Наступним кроком може стати підтримка зображень

ASUS і Acer припинили продаж ноутбуків та роботу сайтів у Німеччині через виграш Nokia в суді Acer Asus Nokia події у світі суд

У 2025 році компанія Nokia подала паралельні позови проти Acer, Asus та виробника телевізорів Hisense до Мюнхенського регіонального суду та Єдиного патентного суду