Видеокарты для геймеров, двухчиповые GeForce от Zotac

08.09.08Мой Компьютер, №14, 01.04.2008

Да и оптимизацией режимов CrossFire и SLI на уровне драйверов производители занимаются гораздо более усердно. При этом особенно заметным этот прирост становится в больших разрешениях с включением опций полноэкранного сглаживания и HDR — именно в тех режимах, ради которых и покупаются видеокарты дороже 300 долларов за штучку. Однако есть в большом разрешении один «подводный камень», о который «разбиваются» двухчиповые решения… Впрочем, теперь nVidia тоже имеет современную двухчиповую видеокарту — nVidia GeForce 9800 GX2. ![]() И мы познакомимся с ней на примере сэмпла от молодой, но уже хорошо известной компании Zotac.

И мы познакомимся с ней на примере сэмпла от молодой, но уже хорошо известной компании Zotac.

|

| Старичок GeForce 7950 GX2 |

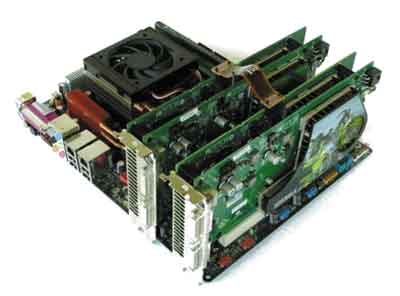

В свое время nVidia удивила мир выходом «двухголового» монстра под названием GeForce 7950 GX2, который представлял собой фактически две отдельные видеокарты, соединенные при помощи интерфейса SLI и имеющие один общий коннектор PCI Express x16. На то время основной выгодой от такого решения была возможность установки SLI-связки в материнские платы с всего одним слотом PCI Express x16 — со всеми вытекающими последствиями (как положительными, в виде прироста fps в тяжелых режимах, так и отрицательными — в виде значительно возрастающего энергопотребления и не всегда удачной оптимизации распараллеливания нагрузки на «половинки» видеокарты). Но, пожалуй, самым важным для получения первенства в имиджевом секторе было то, что после установки 7950 GX2 в режим SLI пользователь фактически получал четыре видеокарты, работающие «в едином порыве». Напомню, что тогда чипсетов и, соответственно, материнских плат, поддерживающих более двух PCI Express x16, не существовало.

Сейчас же, с появлением обновленных версий CrossFire X и 3-way nVidia SLI, такое преимущество сходит на нет, разве что кому-то вздумается попробовать связку из трех-четырех двуядерных видеокарт. Но стоимость такого решения получается совсем уж заоблачной, да и оптимизация упрется в непреодолимую стену, о которой я уже мельком обмолвился. ![]() Пожалуй, сейчас надо раскрыть тему немного подробнее.

Пожалуй, сейчас надо раскрыть тему немного подробнее.

Объем памяти

М

|

|

GeForce 7950 GX2, соединённые в Quad-SLI |

ы уже как-то рассматривали суть процесса разделения работы между двумя видеокартами в процессе отрисовки 3D-изображения. Как минимум, были описаны возможные режимы подобной работы для видеокарт Radeon HD 2xxx, поскольку с этим поколением количество таких режимов у видеокарт ATI значительно увеличилось. Однако суть осталась прежней — итоговый кадр разбивается пополам (возможно, в неравных пропорциях, что особенно актуально для шутеров — видеокарта, отрисовывающая «половинку» с небом, будет нагружена гораздо меньше, чем «половинка», ответственная за часть кадра, на которой видны пальмочки, трава и толпы врагов), либо на несколько прямоугольных областей, либо обрабатывается построчно. Нетрудно понять, что при любом из вышеперечисленных методов обеим видеокартам придется хранить в своей памяти немалое количество общей информации, как о геометрии объектов, так и о текстурах (хотя некоторая часть все же будет отличаться). О режиме попеременной обработки кадров (когда «половинки» двухчиповых видеокарт обрабатывают кадры по очереди) картина получается еще веселее — содержимое памяти обоих видеокарт дублируется практически на 100%. Это все было сказано об ATI, но примерно та же картина наблюдается и у продукции nVidia — от общих принципов технологии никуда не деться.

Как видите, в случае с SLI или CrossFire говорить о совокупном объеме видеопамяти некорректно, равно как и в случае «двухголовых» видеокарт. Поэтому несмотря на то, что на коробке с GeForce 9800 GX2 гордо красуется надпись «1Gb GDDR3», относиться к этому нужно с известной долей скепсиса. Физически там действительно 1 Гб, но вот толку от этого особого нет.

|

|

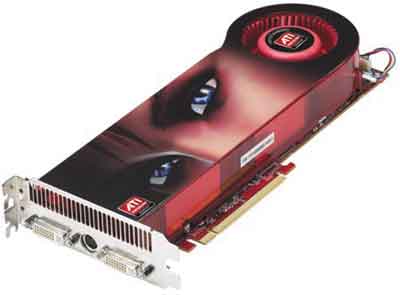

Radeon HD3870 X2 — основной конкурент 9800 GX2 |

Не менее очевидно и то, что никакая оптимизация не поможет решить эту проблему. Как ни разделяй задачи по обработке, как ни расширяй шину PCI Express, все равно от дублирования данных никуда не денешься. Решение (по моему дилетантскому мнению) может быть только одно — и оно уже успешно испытано не на видеопроцессорах, а на обычных CPU. Речь идет о связке двух ядер (или чипов) друг с другом посредством внутренней шины (FSB или HyperTransport) независимо от памяти. Однако не стоит обманываться тем, что ATI Radeon HD 3870 X2 выполнен на одной печатной плате. Несмотря на то, что визуально она является единым целым, на самом деле процессоры RV670 не связаны между собой напрямую. В плату интегрирован свой интерфейс PCI Express, хоть и не связанный с внешним (тем, который на материнской плате), но все-таки являющийся обычным PCI Express’ом и не более того. Поэтому выигрыш от такого CrossFire получается разве что в меньшем физическом расстоянии, которое нужно проходить электрическим импульсам между двумя связками «чип-память». ![]() А уж как они выполнены — в виде отдельных плат или распаяны на одном куске текстолита, — это дело десятое.

А уж как они выполнены — в виде отдельных плат или распаяны на одном куске текстолита, — это дело десятое.

|

|

Сразу вспоминается Терминатор-2 |

Выводов из всего вышесказанного можно сделать два. Первый сводится к тому, что как SLI, так и CrossFire, не стоит собирать из видеокарт с малым количеством видеопамяти. То есть четыре Radeon 3850 256 Мб в режиме CrossFire X на 790-м чипсете AMD будут иметь неслабую суммарную вычислительную мощность (не исключено, что там и GeForce 8800 Ultra будет курить в сторонке), однако если игры, для которых они будут использоваться, объективно требуют более 256 Мб (от одной видеокарты), то толку от подобной «упряжки» практически не будет. Кстати, вопрос о необходимости того или иного количества видеопамяти для современных игр тоже недавно поднимался у нас в журнале, и вопрос тогда стоял о выборе между 256 и 512 Мб. Результат, если помните, получился двояким — 512 Мб нужно не для всех игр, многим хватало и 256 Мб, зато, как и всегда, на производительность видеокарты прежде всего влияла скорость работы памяти и ширина ее шины. Сейчас можно с уверенностью говорить, что 256 Мб будет мало для большинства современных игр, но говорить о том, что уже и 512 Мб недостаточно, пока слишком рано. А посему SLI и CrossFire из таких видеокарт — живее всех живых, и будет чувствовать себя хорошо еще долгое время. В то же время, тут можно прийти и ко второму выводу. Рано или поздно 512 Мб тоже станет мало, однако при покупке видеокарт для SLI или CrossFire покупатель платит за каждые 512 Мб на каждой из видеокарт. И если с двумя видеокартами эта переплата «за воздух» еще не так заметна, то чем больше видеокарт, тем более очевидным становится разрыв между ценой и выгодой от такого решения. Честно говоря, 3-way SLI и CrossFire X из четырех ускорителей в этом свете мне и так кажется оправданным только в довольно редких случаях, когда используется два и более монитора одновременно. Вот тут как раз задачи можно разделять «напрямую» — без потери драгоценных мегабайтов из-за дублирования. Но реально полезную реализацию двух мониторов я пока что видел только в стратегии Supreme Commander (один экран основной, а второй — свободно масштабируемая мини-карта (хотя, неслабая «мини» получается — на весь экран) с теми же возможностями управления юнитами, что и на основном экране). Остальные игры пока что гораздо органичнее смотрятся на одном мониторе с просто большим разрешением.

|

|

G92 во всей красе |

Ну, и чтобы закрыть тему, зададимся вопросом: в каких случаях объем видеопамяти может стать «узким местом»? Ответ известен — в больших, если не сказать, огромных разрешениях. При этом по опыту использования SLI, CrossFire и GeForce 7950 GX2 можно сказать, что как раз в больших разрешениях выгода от многочиповых решений наиболее заметна, а при меньших разрешениях все-таки лучше иметь одночиповое решение с большей частотой. Таким образом в нынешнем виде у обеих технологий использования нескольких видеокарт в одной системе есть некий вполне объективный предел разумного, выше которого не прыгнешь. Впрочем, как я уже и говорил, «двухголовые» видеокарты от этого предела далеки, так что GeForce 9800 GX2 актуален. ![]() К нему, собственно, и перейдем.

К нему, собственно, и перейдем.

Рекбус, краксворд…

|

|

GeForce 9800 GX2 со снятым кожухом |

GeForce 9800 GX2 собран почти по тому же рецепту, что и его предшественник — GeForce 7950 GX2. Отличие заключается лишь в том, что две платы, из которых состоит новая видеокарта, размещены «лицом» друг к другу, что позволило использовать одну общую систему охлаждения на двоих, а не два раздельных кулера с двумя вентиляторами. В итоге, несмотря на логично возросшее тепловыделение, GeForce 9800 GX2 нельзя назвать шумной — она держится на уровне всех современных видеокарт с турбиной аналогичной конструкции (например, GeForce 8800 GTS 640 Мб или Radeon HD 2900 XT) и выигрывает у других «горячих» видеокарт, имеющих однослотовые кулеры (ярчайший пример — серия Radeon X1900). Правда, относительно холодный GeForce 9600 GT и с однослотовым кулером ведет себя потише (то есть — практически бесшумно). Правда, сделать GeForce 9800 GX2 более компактным, чем Radeon HD 3870 X2, у nVidia не получилось. Площадь, занимаемая различными элементами на каждой из печатных плат, конечно, меньше, чем в случае Radeon HD 3870 X2, но при этом пришлось удлинить их и проделать «дырки» для того, чтобы кулер получил доступ к воздуху (на фотографиях все видно). В общем, что в лоб, что по лбу. Единственное, в чем решение AMD/ATi действительно удобнее, так это в том, что на ее видеокарте отсутствует внешний соединительный мостик, который у GeForce 9800 GX2 после разборки замучаешься подключать обратно. Но простому пользователю вряд ли придет в голову разбирать свою видеокарту, так что претензия снимается.

Гораздо интереснее обстоит дело с чипами, использованными в GeForce 9800 GX2. В основу «половинок» этой видеокарты поставлен процессор G92 (также известный как D8P). А это, как известно, чип видеокарт серии GeForce 8800 GTS 512 Mб. То есть, по сути, GeForce 9800 GX2 — это две GeForce 8800 GTS 512 Mб в режиме SLI (правда, со слегка заниженными частотами, 8800 имеет 650 МГц/1.625 ГГц по ядру и шейдерному блоку, а 9800 GX2 — 600 МГц/1.5 ГГц; зато память немного быстрее — против 1.94 ГГц DDR3, GeForce 9800 GX2 имеет честные 2 ГГц). Очевидно, чтобы добавить путаницы в названиях, nVidia выпускает еще и серию одночиповых GeForce 9800, с тем же G92 в качестве видеоядра. У ATi, впрочем, та же «веселая» картина, архитектура Radeon HD 2xxx и Radeon HD 3xxx тоже имеет совсем немного различий, но эта компания хотя бы не выпускает видеокарты с одним видеочипом, но при этом — с разными названиями. А уж тем более — с названиями от разных поколений! В общем, решайте сами, считать GeForce 9800 (любой модификации) на самом деле 8800-м, или же новые 512-мегабайтные GeForce 8800 считайте «бета-версией» девятитысячной серии. Главное понимать, что это — одного поля ягоды, просто GeForce 9800 GX2 звучит солиднее, чем GeForce 8800 GX2, поскольку восьмитысячная серия уже вроде бы как устарела — уже полтора года на рынке.

Ну а теперь — перейдем непосредственно к нашему образцу GeForce 9800 GX2 от компании Zotac.

GeForce 9800 GX2 и его «половинка» во плоти

|

|

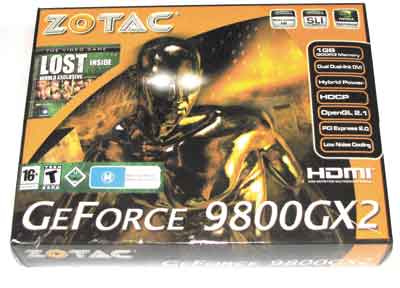

Коробка GeForce 9800 GX2, надпись про 1Гб, в принципе, верна, но если задуматься… |

Упаковка оказалась вполне стандартной для Zotac, даже размеры самой видеокарты не заставили вендора увеличить привычные габариты коробки. Таким образом, на витрине Zotac GeForce 9800 GX2 отличается от своих собратьев разве что нарисованным спереди «жидким терминатором» и, естественно, надписью «GeForce 9800 GX2». Впрочем, при первом же взгляде на ценник все вопросы отпадут сами собой.

Комплект поставки тоже можно описать словосочетанием «ничего лишнего». Внутри обнаружилось следующее добро:

-

мануал и диск с драйверами;

-

игра Lost: Via Domus от Ubisoft;

-

переходник DVI-VGA (d-Sub);

-

HDMI кабель;

-

кабель для подключения к звуковой карте;

-

переходник с двух «молексов» на один шестипиновый PCI-E;

-

переходник с двух шестипиновых PCI-E на один восьмипиновый.

Последние два пункта перечня особенно актуальны в свете того, что GeForce 9800 GX2 требует в качестве дополнительного питания подключение шестипинового и восьмипинового PCI-E одновременно. При этом фокусы с переходниками на восьмипиновый с четырехпинового контакта не проходят, питание требуется более солидное. А раз уж восьмипиновый коннектор может потребоваться для материнской платы (и на многих блоках питания он всего один), то наличие таких переходников жизненно необходимо для будущего владельца GeForce 9800 GX2. Кстати, каждый из дополнительных разъемов питания подсвечивается двумя светодиодами. Красный означает, что питания недостаточно, а зеленый, соответственно, сигнализирует о том, что все в порядке.

Что касается HDMI, то переходник тут не требуется, на GeForce 9800 GX2 есть отдельный HDMI выход, причем с поддержкой вывода звука (для того и припасен в комплекте кабель).

Внешний вид GeForce 9800 GX2 вы можете оценить по фотографиям. Махина знатная, «обшитая» со всех сторон металлической «броней». На одной из плат имеется даже ребро жесткости, хотя, в целом, отличную жесткость обеспечивает система охлаждения. На боковой стороне пристроены два разъема — для цифрового аудиокабеля и для SLI. Оба закрыты легкосъемными крышками.

После разборки перед нашими глазами предстает во всей красе чип G92 и восемь модулей памяти GDDR3 производства Samsung с задержкой 1 нс, что означает номинальную частоту работы — 1 ГГц (или 2 ГГц в режиме DDR). Кулер плотно прилегает как к памяти, так и к видеочипу. В качестве термоинтерфейса для G92 использована серая термопаста довольно плотной консистенции (судя по температурам, на которых работает чип, очень эффективная), а вот для памяти применена белая «жвачка», которую любой уважающий себя продвинутый пользователь заменит на нормальную термопасту.

Теперь — новые технологии. Рассказывать об обновленном PureVideo HD, пожалуй, не буду, а вот про HybridPower нужно сказать пару слов. Эта технология позволяет оптимизировать энергопотребление системы в режимах низкой нагрузки, причем оптимизация задействована самая радикальная — внешние видеокарты могут отключаться полностью, а вся нагрузка ложится на гораздо менее «прожорливое» встроенное видеоядро. Единственным ограничением для использования данной технологии является вопрос поддержки со стороны материнской платы. Естественно, это должна быть плата на базе чипсета nForce с интегрированным видео.

Что касается частот, наш образец от Zotac не принадлежит серии AMP!, в которой выходят только видеокарты с заводским разгоном, и соответствующей версии GeForce 9800 GX2 у Zotac пока нет. Очевидно, посчитали, что GeForce 9800 GX2 и так достаточно мощная штуковина, чтобы ее еще и разгонять. Так что все частоты у нашего героя стандартны.

В качестве «точки опоры» у нас послужит, как уже было сказано выше, «половинка» GeForce 9800 GX2, а именно GeForce 8800 GTS 512 Мб — тоже производства Zotac. Внешне она мало чем отличается от GeForce 8800 GTS 320/640 Мб, поэтому особо расписывать устройство платы и системы охлаждения не стану. А вот по частотам необходимо сделать небольшое уточнение. Этот образец как раз из серии AMP!, поэтому его частотная формула выглядит так: 678/1944/1728 МГц (стандарты я приводил выше). Не то чтобы очень большой разгон, но все же заметный, а от частот GeForce 9800 GX2 (особенно по ядру) так и вообще отличается почти на 80 МГц. ![]() Поэтому сей факт нужно учесть при сравнении.

Поэтому сей факт нужно учесть при сравнении.

|

|

Коробка GeForce 8800 GTS 512 Mb |

Комплект поставки GeForce 8800 GTS 512 Мб производства Zotac ничем особым не отличается. В коробке лежат:

-

мануал и диск с драйверами;

-

ТВ-кабель;

-

переходник DVI-VGA (d-Sub);

-

переходник с двух «молексов» на шестипиновый PCI-E.

Что ж, пора посмотреть, как наши гости покажут себя в деле.

Тестирование

Платформа использовалась старая, хорошо проверенная, хотя ее предел уже практически достигнут. В ближайшее время буду требовать от начальства новых «железяк» :-). Ну а пока имеем вот что:

-

процессор Core 2 Extreme QX6700 2,6 ГГц;

-

материнская плата ECS p35T-A, чипсет intel Р-35;

-

две планки DDR2-800 по 1 Гб;

-

винчестер Hitachi 7200 об/мин;

-

операционная система Windows Vista Enterprise.

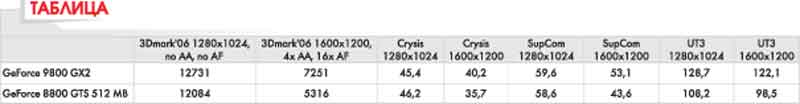

Учитывая особенности нашего сегодняшнего героя, ключевым преимуществом которого является именно работа в особо тяжелых режимах графики, все тесты проводились при максимальных настройках, причем с включением 4х антиалиасинга и анизотропной фильтрации текстур в режиме 16х. Исключение составил только пакет 3Dmark’06 при разрешении 1280х1024, который запускался без AA и AF, поскольку именно в таком режиме были протестированы практически все предыдущие видеокарты, что пригодится тем, кто захочет сравнить с результатами старых тестов. Напомню также и то, что наш процессор набирает в 3Dmark’06 примерно 3700 баллов (колебания результатов незначительны).

Кроме вышеперечисленных особенностей, во всех играх было задействовано два разрешения — 1280х1024 и 1600х1200. На тесты в еще больших разрешениях, к сожалению, не хватило времени, так что будем довольствоваться тем, что есть.

Ну и последняя ремарка: в Supreme Commander, судя по отзывам читателей, результат в баллах, который выдает встроенный бенчмарк, не очень удобен для восприятия при тестах видеокарт. Все-таки изрядная часть этого результата зависит в первую очередь от процессора. Поэтому будем измерять по-новому (вернее, по-старому), запускать все тот же встроенный бенчмарк, но замер производительности проводить начиная с определенной сцены (когда показывают бой между кораблями — к этому моменту fps уже окончательно выравнивается) при помощи утилиты Fraps. На этом — все. Смотрим результаты.

При разрешении 1280х1024 картина получается не совсем радужной для GeForce 9800 GX2. То ли разработчики не особо заботятся об оптимизации под двуядерные видеокарты (что, в принципе, логично, GeForce 9800 GX2 — явно не массовый продукт) и режимы SLI/CrossFire, то ли драйверы у nVidia еще сыроваты. Тем не менее, результат налицо, GeForce 9800 GX2 еле-еле выигрывает несколько fps у своей «половинки», а местами — даже проигрывает! При разнице в цене, составляющей 200 долларов, как-то не очень красиво получается.

Однако все становится на свои места, как только включается разрешение 1600х1200. При такой нагрузке более высокие частоты GeForce 8800 CTS 512 Мб уже не спасают, и GeForce 9800 GX2 выходит в безоговорочные лидеры практически во всех тестах. Правда, не готов утверждать, что даже такое превосходство может оправдать разницу в цене и заметно большее энергопотребление GeForce 9800 GX2 по сравнению с GeForce 8800 GTS 512 Мб.

У вас есть лишние 200 долларов?

Если нет, то в том случае, если вы как раз выбираете себе новую производительную видеокарту, вопросов никаких оставаться не должно. С нынешним уровнем оптимизации GeForce 9800 GX2 начинает показывать заметное преимущество только при очень высоких разрешениях. Кстати, по этой же причине нет абсолютно никакого смысла в покупке «двухголовой» видеокарты до апгрейда монитора, иначе на стандартном 20-дюймовом широкоформатнике с разрешением 1440х900 картинка и fps от GeForce 8800 GTS 512 Мб снова будет выглядеть точно так же, как и от GeForce 9800 GX2. Ну или чуть-чуть медленнее. ![]() Тем не менее, как только речь заходит о совсем уж невообразимых режимах (например, 2560х1600), то тут одноядерным видеокартам пока делать нечего, fps будет ниже порога комфортности.

Тем не менее, как только речь заходит о совсем уж невообразимых режимах (например, 2560х1600), то тут одноядерным видеокартам пока делать нечего, fps будет ниже порога комфортности.

Web-droid редактор

вологість:

тиск:

вітер:

Тест ноутбука ASUS Zenbook Duo 2024: оба два

ASUS Zenbook Duo 2024 – ноутбук с двумя сенсорными экранами, при этом, имеющий дизайн классического устройства. Удалось ли компании реализовать инновации удобно и повысить эффективность работы – разберемся в этом материале

Смотреть Евровидение 2024 на Киевстар ТВ можно будет бесплатно

видео онлайн события в миреУкраину на «Евровидении-2024» будет представлять дуэт alyona alyona & Jerry Heil. Они будут выступать 7 мая в первом полуфинале под номером 5. Дуэт исполнит песню Teresa & Maria

Реактивный БПЛА Veloce 330 с вертикальным взлётом и посадкой разгоняется до 400 км/ч

война дронДрон Veloce 330 сможет летать на дальность 80 км. Заявленная автономность БПЛА — до 3 часов. Veloce 330 устойчив к РЭБ.